|

发布会先是讲了苹果手表和耳机。

耳机产品中有两个点让作者比较惊喜,其中一个是AirPods4支持通过点头和摇头来对一些通知进行控制。

当用户在双手拿着东西的时候突然来电话了,这个时候就可以通过点头来接听电话,或是通过摇头来拒接电话。

第二个点是耳机能够识别用户说话的声音。当用户戴着耳机听音乐突然遇到了熟人。开始和熟人打招呼,这个时候耳机的音量就会自动降低,直到用户和他的朋友结束这一次对话。耳机的音量会自动恢复。

这两个场景都可以算是比较典型的痛点。苹果也通过新技术解决了这两个问题。其实整个发布会看下来,我们会发现苹果很少说AI这个词,一般会用机器学习,神经网络等等来替代,其描述还是更准确一些。

讲完了耳机之后就开始了整个发布会最重要的部分,开始讲iPhone了。用一句话来形容iPhone和AI的关系库克是这样说的:“iphone16是为Apple Intelligence而设计的”。可见AI技术的应用场景在新一代iPhone16中有多么被重视。

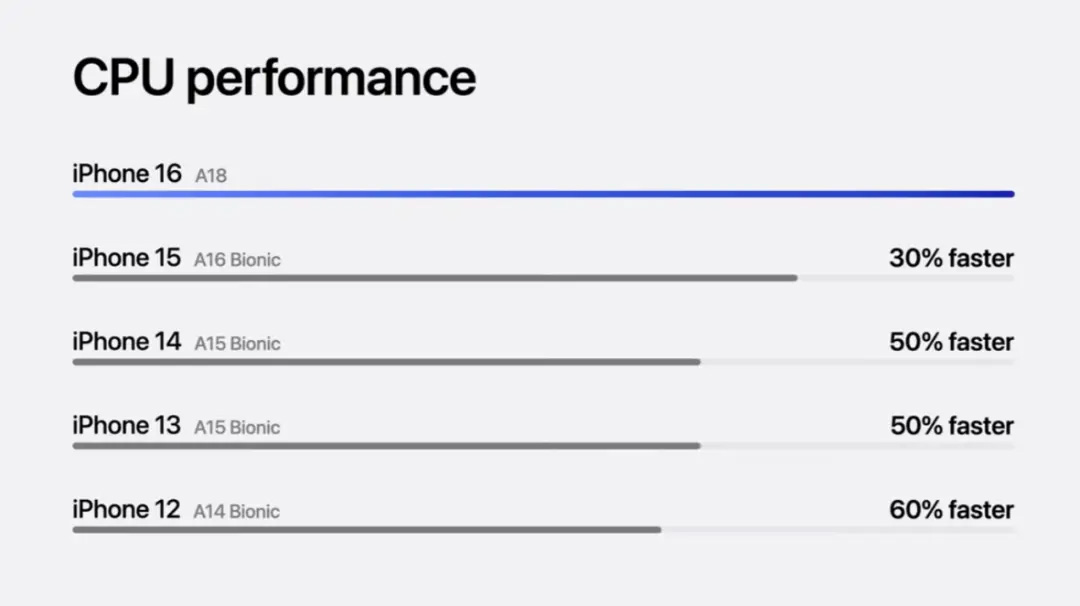

作为AI能力的基础保障iPhone16的CPU升级到了18处理器,相对于上一代iPhone15的处理器跨越了两代。这一点非常惊喜,具体的性能对比见下图。

不只是CPU方面有明显的性能提升,在GPU方面提升也非常巨大,相对于iPhone15提升达到了40%。

硬件性能的提升为iOS系统的各个AI技术的应用场景提供了优秀的保障,下面就来iphopne16的三大重点改变。

一、iPhone16增加了一个实体按钮

这个实体按钮可以被设置成不同的功能。例如可以点击直接开启录音或者是翻译。还可以是某些APP里面某个具体的功能。

这种按钮其实在国产手机努比亚Z60ultra里也有相同的设计,但是能够自定义的能力范围和苹果相比还有一些差距。

这种差距对用户体验的影响还是比较大的,例如走路时走着走着突然想到了一个灵感,这个时候点击一次就能开始录音记录和点击两三次区别非常大。

这个按钮的核心意义就是进一步缩短用户与手机中各种服务的距离。这个设计目标其实几乎已经成为了各个手机厂商的共识。像近几年出现的息屏显示就是为了帮助用户在手机完全没有解锁没有点亮的状态下能够看到一些服务相关的信息。

包括锁屏上可以进行的通知可以放置的。应用小部件都是基于同样的目标产生的设计方案。国产手机厂商中OPPO曾经做了一些服务原子化的能力,也是基于这个目标。

除此之外,iPhone16还展示了其他几种AI能力的具体应用。但实际上这些能力都没有超出我们已经看到过的AI产品的能力。具体如下:

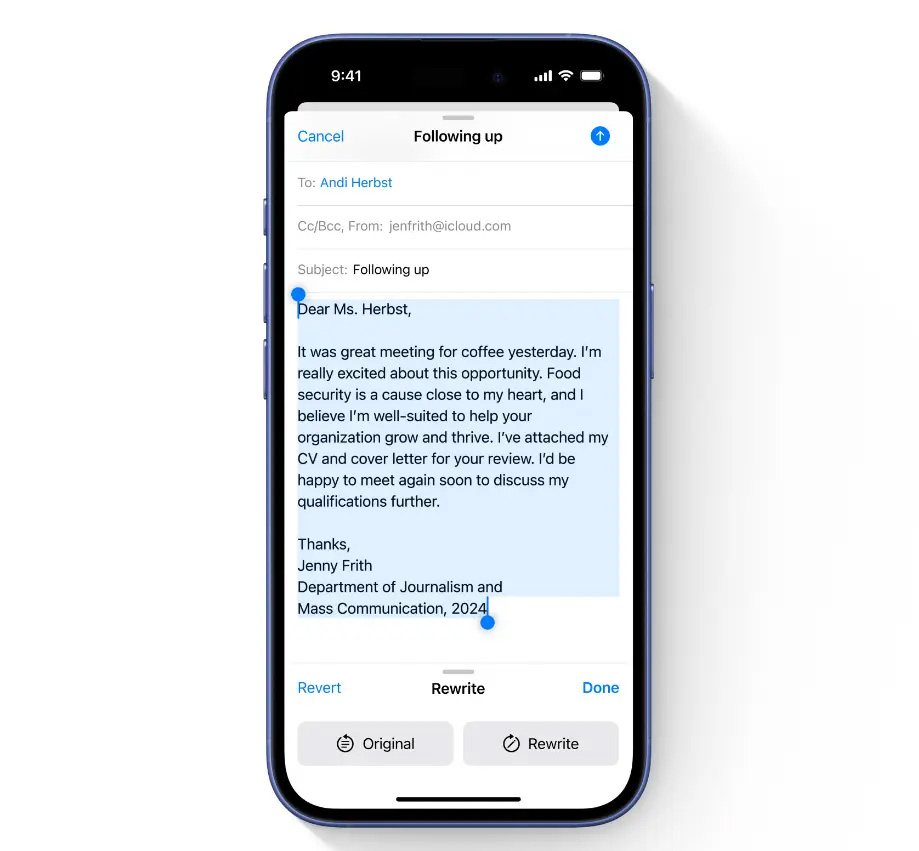

1、文字写作能力

例如在邮件中可以基于用户写的内容进行改写,使内容更加适合对话场景,例如更适合工作场景的语气和措辞。

这个能力不仅限于在苹果自家的应用中使用,按照发布会中的介绍,这个能力几乎可以在任何第三方应用中使用是一个系统级的能力。

2、文字理解能力

这个能力主要会应用在一些提醒的场景中。例如在手机的通知中心以前我们只能根据通知的时间来进行排序,但是时间并不能代表这条通知是否重要。甚至会由于通知的排序。完全依照时间而导致我们错过一些重要的信息。

而有了文字理解能力之后,系统就会去理解通知中包含的具体信息。例如可能可以识别广告信息,把这些理解为不重要的信息,可能会识别某个联系人发过来的内容,标记为一条重要的信息。

这样就可以按照重要程度,至少可以按照重要和不重要两类来对通知进行区分,帮助用户获取更重要的内容。

除了通知的场景,在邮件的场景这个能力也很重要。传统的邮件除了标题之外,我们往往只能看到开头的一两行文字,而这一两行文字往往又是一些无意义的文字。

下面这张图片是作者邮箱中一封真实的邮件。他的本意是想提醒我。有一款我感兴趣的游戏正在打折。引导用户去购买。

但实际上在我没有查看详情之前,甚至无法知道具体是哪一款游戏正在打折。而恰恰是这个最重要的信息是无法被识别到的。

而有了文字理解能力之后就可以对邮件的内容形成摘要例如把上面那张图片中的信息写为艾尔登法环正在打9折,这样就比现有的信息有效很多。

下面这张图是苹果发布会中的截图:

3、图/视频理解能力

手机操作系统中对于图片和视频的理解能力主要会被应用在相册应用的搜索功能上。这个能力其实已经并不新鲜了,我们在小米手机中就可通过搜索图片中包含的内容来找到一张图片。

而苹果发布会展示的这项能力,好像在搜索条件的复杂程度上有一些突破。因为以作者实际的经历来看,在小米中我只搜索过单个的物体,例如某个图片中包含翅膀。

而苹果发布会中演示的可以是一个带有描述词的长句子。这一能力具体的范围可能还需要拿到真机之后才能确定。

4、图/视频生成能力

除搜索图片之外,在使用已有的图片生成视频时,这一能力也很重要。其实就是找到很多有关系的图片制作成一个影集视频的功能。

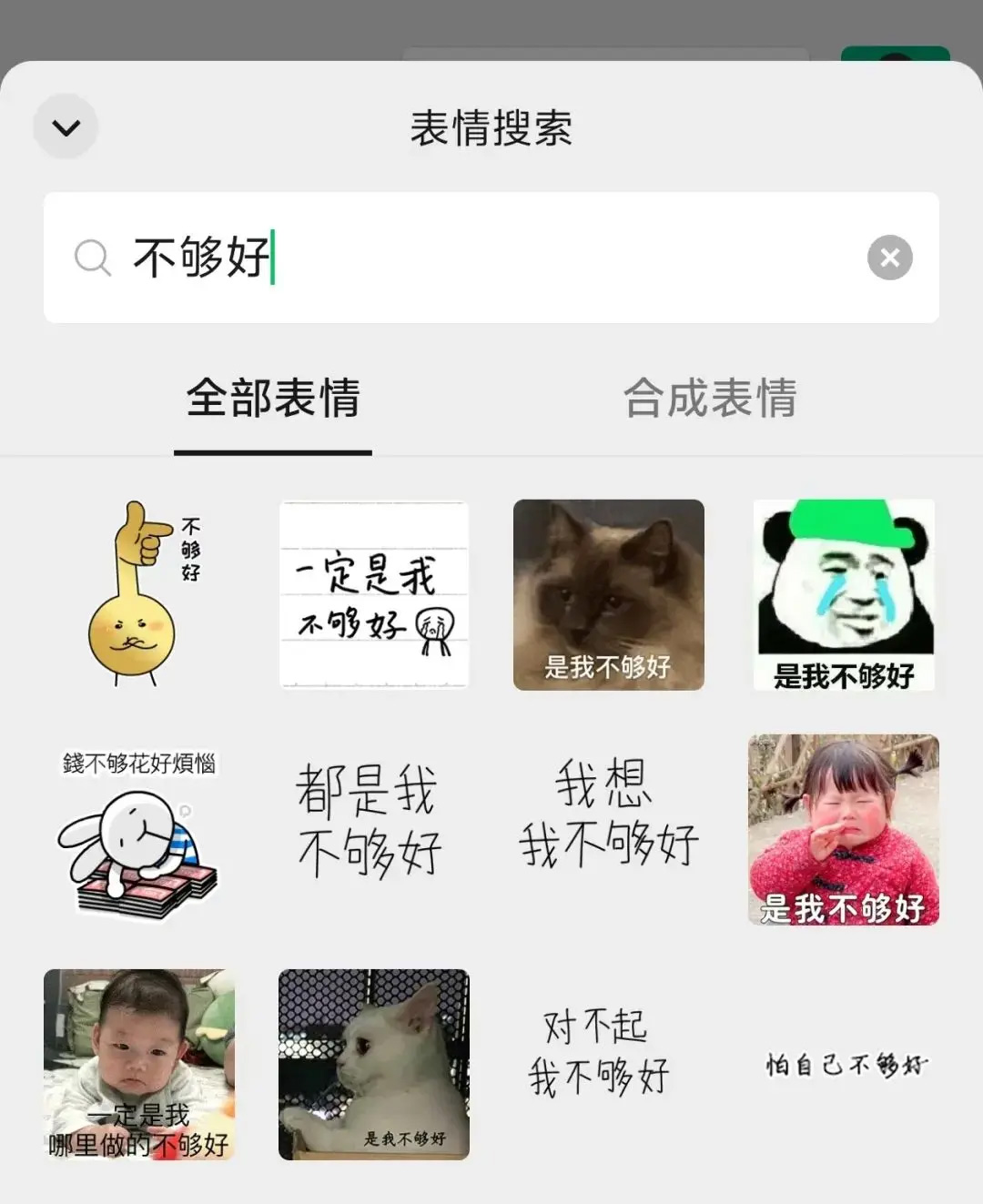

对于图片的生成,发布会中也用了声中表情这个场景来进行演示。在输入框中输入文字就可以生成对应的表情图片,如下图:

纹身图的能力我们都已经很熟悉了,但是作者确实觉得苹果打的这个场景对于中国用户来说不够好。

因为微信中自带的搜索表情包的能力。实际使用上要比单个的图片生成体验更好,可以有更多的选择,更快的速度以及一些更有趣的内容。如下图:

除了生成图片之外,对于图片的编辑能力苹果也进行了介绍,这方面都是老生常谈了,就不详细展开了。

重点来了!!

如果说这次发布会中选出三个最重要的内容的话,那么作者觉得有两个是硬件上的改动。一个是软件层面的新东西。

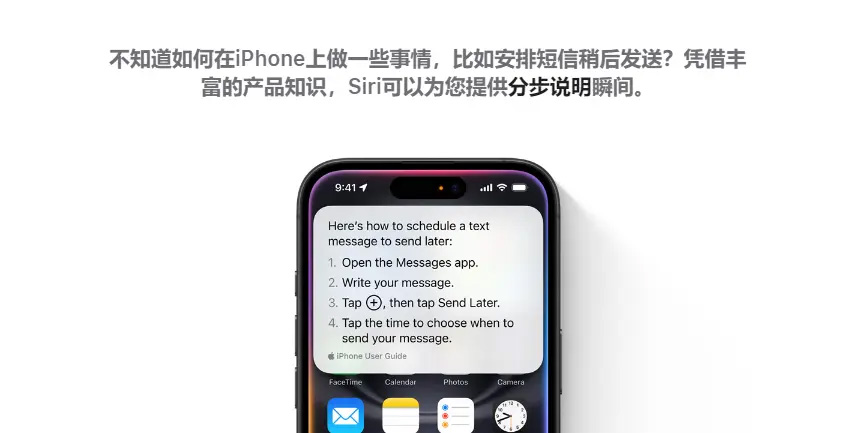

二、脱胎换骨的siri

以前的Siri虽然也能回答一些简单的问题,但是对于控制手机方面的能力是非常弱的,而全新的Siri可以完成非常复杂的任务。

例如通过语音操控就可以完成打开某个应用。找到特定信息,再把它分享给另一个应用中的某个联系人。对于操作系统的控制可以贯穿于多个应用和几乎全量信息之中。

按照苹果官网的介绍,在买票的场景下可以自动找到对应的身份号码完成买票的操作。

如果用户和他的朋友在某个聊天产品中进行对话,他的朋友推荐了一首歌,这个时候用户可以直接向Siri发布播放的命令。

Siri可以识别到屏幕上的内容。准确理解用户的意图,完成播放任务,这种基于屏幕内容识别和大量上下文记忆的能力在长期使用的设备中意义非常重大,可以减少非常多信息的重复表述,提升操作效率。

全新的Siri其实更像是一个通用Chatbot了。除了上面所说的完成任务之外,还可以像使用ChatGPT那样与他进行对话,回答问题的能力生成内容的能力都有了极大的提升。

尤其是对话时,对于信息的识别接收能力变得非常强,在对话式交互的过程中,有一个难点就是在没有练习过的句子人类很难非常流畅的完成表达。

一般可能会有多次的停顿或者是错误的读音,说错的信息等等。大家可以联想一下在微信里发语音的过程,我们是不是经常会遇到说错了话之后取消发送,又不得不重新从头儿开始讲的时候。

这种方式其实对语音交互的效率影响非常大,而苹果这次演示的与Siri对话的过程,即使用户说的话是磕磕巴巴的,还有错误,然后又纠正。最后依然得到了正确的结果。

这种能力其实有点像现在的语音笔记产品。都是对于一些非常口语化的,容易出错的语音内容进行识别之后,再用大模型的能力进行纠正改写,然后得到一些更为正确的书面化的信息。

这个过程是让命令更准确的过程,也是让机器能以更高成功率完成任务的能力。

三、最后一个重点是相机控制按钮

要注意这个按钮和我们刚才所说的自定义功能按钮并不是一个而是两个独立的按钮,在最新的iPhone16上,右侧是开机和相机按钮,左侧是自定义功能按钮以及音量按钮。

虽然发布会中把这个按钮也称作相机相机。但仔细的理解之后就会发现这个按钮其实是Apple Intelligence的重要交互入口。

作为相机的控制方式,这个按钮虽然实现了更快速的打开相机进行抓拍,并且也能够通过单击,双击,滑动等等方式快速方便的使用相机相关的功能。

但作者觉得这个按钮更应该被理解成Apple Intelligence的入口。

原因是苹果把相机作为了设备与环境交互的最重要媒介。就像发布会中演示的,通过相机可以识别一家。餐厅,然后去看这家餐厅相关的评价,找到预定这家餐厅位置的入口。

其他的场景还有拍照搜索商品。在路上看到了一个很喜欢的自行车。直接用这个按钮调用相机之后就可以通过谷歌找到相同商品的购买链接。

这方面的应用非常重要。就像现在国内都在做的AI搜索产品,其实还没有一个明确的商业模式。

之前在和一些做AI搜索产品的朋友交流时也会发现,大家其实都能够意识到搜索后服务是比较重要的,但是Aftersearch能够关联上什么服务还没有一个明确的答案。

有的公司认为是要做内容社区,但是作者觉得这个方向比较远,也比较虚。有的公司觉得是要做个人知识库。相对靠谱一些但成功的几率也不是很大。

电商其实是一种变现模式非常明确的选择,但是产品得成为流量的来源才可以。就像上面所说的苹果选择了相机作为设备与环境交互的主要媒介就存在这个潜力,用户的很多种需求的起点都有可能变成相机。

如果用户能够形成把相机作为很多种目的的起点。那么后续可以衔接的其他业务就非常多了。并且这种交互方式相对于GUI界面的点击方式也存在效率上的优势。

整个发布会在作者认知中的三大重点已经讲完了~

|